ConcurrentHashMap 是线程安全的 HashMap。此前,HashTable 一直被认为是线程安全的 HashMap,ConcurrentHashMap 相对于 HashTable 采用了 锁分段机制 ,即将原本对整个对象加锁的实现进行粒度细化。这也是源于 HashMap 基本的存储特性,因为许多读写请求都是被哈希到了互相独立的区域,这种情况下即使并发读写也不会相互影响,更不会有线程安全问题,而对于操作加全局锁的实现方式显然是浪费了这一天然的并发优势,我们需要加锁的位置是真正存在竞争的地方,而分段锁很好的利用了这一特点。

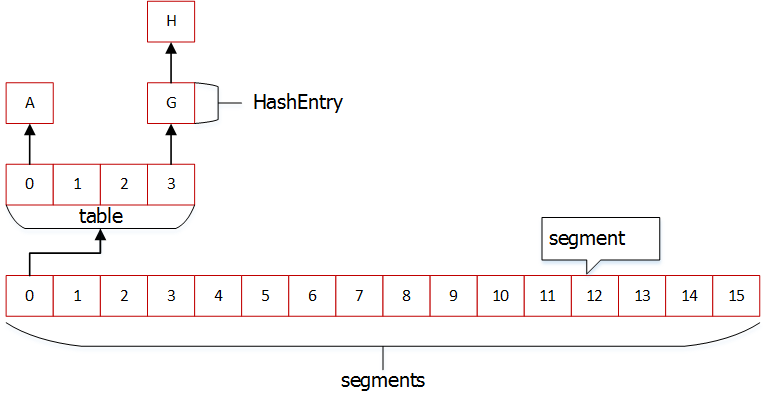

在实现上,ConcurrentHashMap 内置了两个静态内部类 HashEntry 和 Segment,前者用来封装 key/value,后者则用来充当锁的角色。一个 Segment(分段)上挂载着一张包含多行记录的表(table),负责范围内各个结点读写的线程安全,每行记录都是由一个以 HashEntry 为结点的链表构成。

上面这张图具体描绘了 ConcurrentHashMap 的存储结构设计,默认情况下一个 ConcurrentHashMap 包含 16 个分段(Segment),每个分段包含一张表(HashEntry 类型数组 table),而表中的每行记录都是一个包含了若干个 HashEntry 类型结点的链表,HashEntry 可以看作是整个存储结构中最小的存储单元。在这样的存储结构基础上,我们可以初步臆测 ConcurrentHashMap 存储、读取数据的实现过程,概括来说就是先基于 key 的哈希值定位到具体的分段,然后映射到对应的表,最后就是对表中链表的常规遍历操作。而在这个过程中,锁的粒度控制在一个分段范围内,也就是说只有哈希到同一个分段内的多个读写操作才会存在竞争,而分段与分段之间的读写操作则互不影响、并发执行。段内竞争的线程安全则以具体的分段对象作为锁来执行同步策略,所以在默认理想情况下,一个 ConcurrentHashMap 具备 16 个线程的并发读写能力,这相对于对整个存储对象加全局锁的 HashTable 来说,效率提升了许多。

我们先来分别看一下 HashEntry 和 Segment 这两个基础组件的内部结构实现,首先来看一下 HashEntry:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 static final class HashEntry <K ,V > final int hash; final K key; volatile V value; volatile HashEntry<K,V> next; HashEntry(int hash, K key, V value, HashEntry<K,V> next) { this .hash = hash; this .key = key; this .value = value; this .next = next; } }

HashEntry 是对 key/value 的封装类,可以将一个 HashEntry 对象看做是整个存储结构中的最小单位,它是一个结点,包含了必要的 hash、key、value 元素,因为采用链地址法来解决冲突,所以还包含了链表的 next 指针。四个属性中 hash 和 key 是 final 修饰的,而 value 和 next 则是由 volatile 来修饰,这样的设计最根本的都是希望保证在并发访问过程中结点的线程可见性,又因为后两者是可变的对象,所以采用 volatile 进行修饰。

再来看一下 Segment 的实现,Segment 实现了 ReentrantLock 类,所以可以将其视为一个针对 HashMap 作了适配的可重入锁,每个 Segment 对象的责任就是用来保证其守护的表内各个结点访问的线程安全:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 static final class Segment <K ,V > extends ReentrantLock implements Serializable private static final long serialVersionUID = 2249069246763182397L ; static final int MAX_SCAN_RETRIES = Runtime.getRuntime().availableProcessors() > 1 ? 64 : 1 ; transient volatile HashEntry<K,V>[] table; transient int count; transient int modCount; transient int threshold; final float loadFactor; Segment(float lf, int threshold, HashEntry<K,V>[] tab) { this .loadFactor = lf; this .threshold = threshold; this .table = tab; } }

Segment 可以理解为分段,默认 ConcurrentHashMap 包含 16 个分段,对应的属性已经在代码中注释,这里再进一步讲解一下 table 属性,因为它是存储结构的一份子。table 属性是一个 HashEntry 类型的数组,每个数组元素都是一个 HashEntry 链表。HashEntry 的名字取的个人觉得既好也不好,说其好是因为每个链表的起始节点也是 HashEntry 类型,可以形象的称其为“入口”,但是具体到链表中的每个结点应该用 Node 来表示更加形象,不过真正理解了也就不会因为名字而疑惑。

接下来我们继续探究 ConcurrentHashMap 基于 HashEntry 和 Segment 的实现,实际上是对前面的存储结构图示的具体描述:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 public class ConcurrentHashMap <K , V > extends AbstractMap <K , V > implements ConcurrentMap <K , V >, Serializable private static final long serialVersionUID = 7249069246763182397L ; static final int DEFAULT_INITIAL_CAPACITY = 16 ; static final float DEFAULT_LOAD_FACTOR = 0.75f ; static final int DEFAULT_CONCURRENCY_LEVEL = 16 ; static final int MAXIMUM_CAPACITY = 1 << 30 ; static final int MIN_SEGMENT_TABLE_CAPACITY = 2 ; static final int MAX_SEGMENTS = 1 << 16 ; static final int RETRIES_BEFORE_LOCK = 2 ; final int segmentMask; final int segmentShift; final Segment<K,V>[] segments; transient Set<K> keySet; transient Set<Map.Entry<K,V>> entrySet; transient Collection<V> values; public ConcurrentHashMap (int initialCapacity, float loadFactor, int concurrencyLevel) if (!(loadFactor > 0 ) || initialCapacity < 0 || concurrencyLevel <= 0 ) throw new IllegalArgumentException(); if (concurrencyLevel > MAX_SEGMENTS) concurrencyLevel = MAX_SEGMENTS; int sshift = 0 ; int ssize = 1 ; while (ssize < concurrencyLevel) { ++sshift; ssize <<= 1 ; } this .segmentShift = 32 - sshift; this .segmentMask = ssize - 1 ; if (initialCapacity > MAXIMUM_CAPACITY) initialCapacity = MAXIMUM_CAPACITY; int c = initialCapacity / ssize; if (c * ssize < initialCapacity) ++c; int cap = MIN_SEGMENT_TABLE_CAPACITY; while (cap < c) cap <<= 1 ; Segment<K,V> s0 = new Segment<K,V>(loadFactor, (int )(cap * loadFactor), (HashEntry<K,V>[])new HashEntry[cap]); Segment<K,V>[] ss = (Segment<K,V>[])new Segment[ssize]; UNSAFE.putOrderedObject(ss, SBASE, s0); this .segments = ss; } public ConcurrentHashMap (int initialCapacity, float loadFactor) this (initialCapacity, loadFactor, DEFAULT_CONCURRENCY_LEVEL); } public ConcurrentHashMap (int initialCapacity) this (initialCapacity, DEFAULT_LOAD_FACTOR, DEFAULT_CONCURRENCY_LEVEL); } public ConcurrentHashMap () this (DEFAULT_INITIAL_CAPACITY, DEFAULT_LOAD_FACTOR, DEFAULT_CONCURRENCY_LEVEL); } public ConcurrentHashMap (Map<? extends K, ? extends V> m) this (Math.max((int ) (m.size() / DEFAULT_LOAD_FACTOR) + 1 , DEFAULT_INITIAL_CAPACITY), DEFAULT_LOAD_FACTOR, DEFAULT_CONCURRENCY_LEVEL); putAll(m); } }

具体的属性含义参考代码注释,我们来看一下构造函数的内部逻辑。构造函数允许我们指定 initialCapacity、loadFactor,以及 concurrencyLevel 三个参数值,其中 loadFactor 译为装载因子,在数据结构课程中讲解哈希冲突时已经对相关概念解释的比较清楚,这里不再多做说明,默认为 0.75,一般不建议修改。

我们来看一下 initialCapacity 和 concurrencyLevel 两个参数,这两个参数一起用来控制构造 map 的初始化大小,其中 concurrencyLevel 用来控制分段的数目,构造函数会计算得到大于该值的最小二次幂作为 map 的分段数目,因为分段数目的多少对应着并发度的多少,所以参数命名为 concurrencyLevel 也不难理解。之所以需要用大于该值的最小二次幂作为分段大小,主要是为了配合哈希函数的定义, 方便通过逻辑与运算来定位具体的分段 ,相对于数值运算来说这样效率更高。再来看一下 initialCapacity,该参数用来控制整个 map 集合包含结点的的初始值,最终还是用来控制分段内表的记录行数。

探究了 ConcurrentHashMap 的存储结构设计,我们继续来看一下常用操作的实现细节。对于 Map 集合来说,常用的方法有添加(put)、获取(get)、删除(remove)键值,以及对这些基本方法的包装方法,此外还有获取集合大小(size)等操作,下面我们针对 ConcurrentHashMap 中典型方法逐个说明。

首先来看一下 put 方法,我们都知道 put 操作会修改集合中的数据,也就是写操作,而写操作若希望保证线程安全和可见,则需要一定的同步策略。ConcurrentHashMap 的写操作相对于 HashTable 要高效很多,这主要归功于锁分段机制,具体的实现如下:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 public V put (K key, V value) Segment<K,V> s; if (value == null ) throw new NullPointerException(); int hash = hash(key); int j = (hash >>> segmentShift) & segmentMask; if ((s = (Segment<K,V>)UNSAFE.getObject(segments, (j << SSHIFT) + SBASE)) == null ) s = ensureSegment(j); return s.put(key, hash, value, false ); }

上述过程的逻辑比较明确,可以概括成如下三步:

调用 hash 方法计算 key 的哈希值

基于 key 的哈希值定位具体的分段 Segment

调用 Segment 对象的 put 方法执行 put 逻辑

从整个操作过程我们可以很直观的理解锁分段的实现细节,Segment 就是这里的锁对象,put 操作会首先定位当前需要操作的具体 Segment 对象,然后调用该对象的 put 方法执行写入或更新操作,而具体的锁策略就位于 Segment 的 put 方法内,这个我们后面再深入探究,先来看一下定位具体分段的过程,首先看一下 hash 算法的实现:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 private int hash (Object k) int h = hashSeed; if ((0 != h) && (k instanceof String)) { return sun.misc.Hashing.stringHash32((String) k); } h ^= k.hashCode(); h += (h << 15 ) ^ 0xffffcd7d ; h ^= (h >>> 10 ); h += (h << 3 ); h ^= (h >>> 6 ); h += (h << 2 ) + (h << 14 ); return h ^ (h >>> 16 ); }

1 2 3 4 5 6 7 8 9 private transient final int hashSeed = randomHashSeed(this );private static int randomHashSeed (ConcurrentHashMap instance) if (sun.misc.VM.isBooted() && Holder.ALTERNATIVE_HASHING) { return sun.misc.Hashing.randomHashSeed(instance); } return 0 ; }

之所以不直接使用 jdk 提供的 hashCode() 方法,而是在此基础上进行改写(Wang/Jenkins Hash),主要是考虑到原生哈希算法冲突的可能性较大,而哈希均衡是 ConcurrentHashMap 良好性能的基础,下面的例子证明了改写之后的算法在哈希均衡性上优于原生算法:

我做了一个测试,不通过再哈希而直接执行哈希计算。

System.out.println(Integer.parseInt(“0001111”, 2) & 15);

计算后输出的哈希值全是15,通过这个例子可以发现如果不进行再哈希,哈希冲突会非常严重,因为只要低位一样,无论高位是什么数,其哈希值总是一样。我们再把上面的二进制数据进行再哈希后结果如下,为了方便阅读,不足32位的高位补了0,每隔四位用竖线分割下。

0100|0111|0110|0111|1101|1010|0100|1110

可以发现每一位的数据都散列开了,通过这种再哈希能让数字的每一位都能参加到哈希运算当中,从而减少哈希冲突。

例子引用自 聊聊并发 — 深入分析ConcurrentHashMap

然后方法会基于计算得到的哈希值定位具体的分段:

1 2 3 int j = (hash >>> segmentShift) & segmentMask;if ((s = (Segment<K,V>)UNSAFE.getObject(segments, (j << SSHIFT) + SBASE)) == null ) s = ensureSegment(j);

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 private Segment<K,V> ensureSegment (int k) final Segment<K,V>[] ss = this .segments; long u = (k << SSHIFT) + SBASE; Segment<K,V> seg; if ((seg = (Segment<K,V>)UNSAFE.getObjectVolatile(ss, u)) == null ) { Segment<K,V> proto = ss[0 ]; int cap = proto.table.length; float lf = proto.loadFactor; int threshold = (int )(cap * lf); HashEntry<K,V>[] tab = (HashEntry<K,V>[])new HashEntry[cap]; if ((seg = (Segment<K,V>)UNSAFE.getObjectVolatile(ss, u)) == null ) { Segment<K,V> s = new Segment<K,V>(lf, threshold, tab); while ((seg = (Segment<K,V>)UNSAFE.getObjectVolatile(ss, u)) == null ) { if (UNSAFE.compareAndSwapObject(ss, u, null , seg = s)) break ; } } } return seg; }

默认在构造 ConcurrentHashMap 对象时,segmentShift 值为 28,segmentMask 值为 15,而 hash 值为 32 为,所以这里的计算逻辑是对 hash 右移 28 位,再与 segmentMask 执行与操作,目的是让高 4 位也参与到哈希运算中,最终计算得到对应 segments 数组下标。然后基于下标获取对应的分段,如果分段不存在的话,则会基于 CAS 策略创建并记录相应的分段对象。

接着会调用获取到的 Segment 对象的 put 方法执行 put 操作,记录 key/value 值,其中包含了分段锁机制的具体实现细节:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 final V put (K key, int hash, V value, boolean onlyIfAbsent) HashEntry<K,V> node = tryLock() ? null : scanAndLockForPut(key, hash, value); V oldValue; try { HashEntry<K,V>[] tab = table; int index = (tab.length - 1 ) & hash; HashEntry<K,V> first = entryAt(tab, index); for (HashEntry<K,V> e = first;;) { if (e != null ) { K k; if ((k = e.key) == key || (e.hash == hash && key.equals(k))) { oldValue = e.value; if (!onlyIfAbsent) { e.value = value; ++modCount; } break ; } e = e.next; } else { if (node != null ) node.setNext(first); else node = new HashEntry<K,V>(hash, key, value, first); int c = count + 1 ; if (c > threshold && tab.length < MAXIMUM_CAPACITY) rehash(node); else setEntryAt(tab, index, node); ++modCount; count = c; oldValue = null ; break ; } } } finally { unlock(); } return oldValue; }

如代码注释所示,整个过程还是比较直观的,在代码一开始会尝试锁定当前分段对象,锁定之后就是常规的链表操作,因为整个操作位于临界区中,所以无需再考虑线程安全问题。而具体的实现正如我们一开始简单臆测的一样,首先通过与操作定位 key 在表中的记录行,然后对行上的链表执行遍历,如果对应的 key 已经存在则更新对应的 value,否则在链表最前端插入新的结点。因为 HashEntry 中 value 属性采用 volatile 修饰,所以能够保证更新操作能够立即对 get 线程可见,而之所以要采取前置插入是考虑到一个概率问题,HashMap 的开发者认为 后面插入的 Entry 被检索的概率更大,从而提升整体 get 性能 ,并且读操作是不需要加锁的,个人觉得前置插入还可以保证在插入的过程中如果存在读线程在遍历当前链表,则插入操作不会对整个遍历过程产生影响。

再来看一下 get 操作,相对于 put 操作而言,get 要简单许多,这是因为读的过程是不需要加锁的,HashEntry 的设计能够保证节点变更的线程可见性。而结合对于存储结构设计的理解,即使不看源码,我们也能够大致知道整个过程的实现细节,这里不再展开说明。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 public V get (Object key) Segment<K,V> s; HashEntry<K,V>[] tab; int h = hash(key); long u = (((h >>> segmentShift) & segmentMask) << SSHIFT) + SBASE; if ((s = (Segment<K,V>)UNSAFE.getObjectVolatile(segments, u)) != null && (tab = s.table) != null ) { for (HashEntry<K,V> e = (HashEntry<K,V>) UNSAFE.getObjectVolatile(tab, ((long )(((tab.length - 1 ) & h)) << TSHIFT) + TBASE); e != null ; e = e.next) { K k; if ((k = e.key) == key || (e.hash == h && key.equals(k))) return e.value; } } return null ; }

remove 操作类似于 put 操作,都是需要对存储结构进行修改的操作,put 是插入或更新结点,而 remove 则是删除结点,所以都需要进行加锁操作。整个过程同样也分为三个步骤:

计算 key 对应的哈希值

基于 key 的哈希值定位具体的分段 Segment

调用 Segment 对象的 remove 方法执行删除逻辑

1 2 3 4 5 6 7 8 public V remove (Object key) int hash = hash(key); Segment<K,V> s = segmentForHash(hash); return s == null ? null : s.remove(key, hash, null ); }

Segment 对象作为具体的锁对象,所以加锁的细节同样位于 Segment 的 remove 方法中(如下),而具体的实现细节比较直观,做代码注释所示,不再过多撰述。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 final V remove (Object key, int hash, Object value) if (!tryLock()) scanAndLock(key, hash); V oldValue = null ; try { HashEntry<K,V>[] tab = table; int index = (tab.length - 1 ) & hash; HashEntry<K,V> e = entryAt(tab, index); HashEntry<K,V> pred = null ; while (e != null ) { K k; HashEntry<K,V> next = e.next; if ((k = e.key) == key || (e.hash == hash && key.equals(k))) { V v = e.value; if (value == null || value == v || value.equals(v)) { if (pred == null ) setEntryAt(tab, index, next); else pred.setNext(next); ++modCount; --count; oldValue = v; } break ; } pred = e; e = next; } } finally { unlock(); } return oldValue; }

最后我们来一起看一下 size 方法,该方法用于返回当前 map 集合所包含的结点总数目。前面讲解 Segment 类设计的时候,介绍过该类包含一个 count 属性,用于记录分段内结点的总数,并且在具体插入或删除分段内结点时会更新该属性值,那么是不是说这里的 size 方法只需要对所有分段的 count 累加求和返回就行了呢?如果是这样的话那么这里势必要对所有分段加锁,以保证计算的过程中分段内的结构不被更改,否则获取到的 count 极有可能是过期的数据,但是这样的操作性能上将是不太乐观的。

方法 size 的具体实现并没有一上来就加锁,而是先尝试两遍不加锁的累加求和方式,如果两次中所有结点的总数并没有发生变化,则认为计算得到的 size 是可信的,直接返回而不需要加锁,否则再加锁求和也不迟,基于概率统计,这样的设计能够在很大程序上提升整个 ConcurrentHashMap 的性能。具体实现见下面代码注释:

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 public int size () final Segment<K,V>[] segments = this .segments; int size; boolean overflow; long sum; long last = 0L ; int retries = -1 ; try { for (;;) { if (retries++ == RETRIES_BEFORE_LOCK) { for (int j = 0 ; j < segments.length; ++j) ensureSegment(j).lock(); } sum = 0L ; size = 0 ; overflow = false ; for (int j = 0 ; j < segments.length; ++j) { Segment<K,V> seg = segmentAt(segments, j); if (seg != null ) { sum += seg.modCount; int c = seg.count; if (c < 0 || (size += c) < 0 ) overflow = true ; } } if (sum == last) break ; last = sum; } } finally { if (retries > RETRIES_BEFORE_LOCK) { for (int j = 0 ; j < segments.length; ++j) segmentAt(segments, j).unlock(); } } return overflow ? Integer.MAX_VALUE : size; }

以上主要列举了典型的几个操作的具体实现细节,实际上只要理解了整个 ConcurrentHashMap 的存储结构设计,具体方法的实现源码阅读起来将会简单许多,甚至有时候会觉得就是应该这样编码实现。不得不说锁分段技术是一种很巧妙的设计,简单的技术原理,简单的源码实现,却能够极大的提升并发的性能。

但最后还是要泼一盆凉水,在写作本文时,jdk 1.8 已经发布,1.8 版本的 ConcurrentHashMap 彻底摒弃了锁分段技术,转而采用 CAS 机制,并引入了红黑树以解决链表过长而导致的性能低下问题,所有的改进都是为了性能的提升,不过这也增加了代码的实现复杂度,1.7 版本的 ConcurrentHashMap 源码仅 1600 多行,而 1.8 版本则增加到 6000 多行,如此复杂的实现不得不让人再次敬佩 Doug Lea 基于 CAS 机制的 ConcurrentHashMap 实现内幕 》的文章,从源码层面探究 1.8 版本 ConcurrentHashMap 的实现细节。

jdk 1.7 源码

java 并发编程实战 探索 ConcurrentHashMap 高并发性的实现机制 聊聊并发 — 深入分析 ConcurrentHashMap